Редизайн – рано или поздно через него проходит любой проект: захотели сменить дизайн, доменное имя, обновить перелинковку (особенно в свете апдейтов алгоритмов от поисковых систем) или сделать так, как описано в статье Поисковое продвижение по высококонкурентным запросам, т.е. сделать ход конём – 301-ым редиректом. Но проблема заключается не в самом редизайне, а в масштабируемости этого действия. Даже в проекты с сотней страниц могут вкрасться баги – ссылки, ведущие в никуда/битые ссылки и, как следствие, 404-я страница. Она не нравится не только посетителям вашего сайта, но и поисковикам. И, наверное, не стоит говорить, что может быть с проектом в тысячи страниц! Но от редизайна не уйти, поэтому кто-то привык всё делать самостоятельно, а кто-то подключает для этой работы фрилансеров или SEO конторы. И тут встает вопрос о бюджете, точнее о его экономии, поэтому не лишним будет узнать об автоматизации поиска битых ссылок. Что используют в основном для поиска битых ссылок – старую проверенную временем Зенку или Xenu Links. Да, это отличный вариант для SEO оптимизаторов, но есть ещё одна шустрая программка — Screaming Frog SEO Spider, функционал которой намного шире чем у Зенки. Более того, она переходит по сайту по принципу Googlebot’а – это позволит отыскать битые ссылки, о которые может споткнуться Гуглбот. Ну а для того чтобы победить в этом противостоянии, необходимо «порхать как бабочка и жалить как пчела».

Редизайн – рано или поздно через него проходит любой проект: захотели сменить дизайн, доменное имя, обновить перелинковку (особенно в свете апдейтов алгоритмов от поисковых систем) или сделать так, как описано в статье Поисковое продвижение по высококонкурентным запросам, т.е. сделать ход конём – 301-ым редиректом. Но проблема заключается не в самом редизайне, а в масштабируемости этого действия. Даже в проекты с сотней страниц могут вкрасться баги – ссылки, ведущие в никуда/битые ссылки и, как следствие, 404-я страница. Она не нравится не только посетителям вашего сайта, но и поисковикам. И, наверное, не стоит говорить, что может быть с проектом в тысячи страниц! Но от редизайна не уйти, поэтому кто-то привык всё делать самостоятельно, а кто-то подключает для этой работы фрилансеров или SEO конторы. И тут встает вопрос о бюджете, точнее о его экономии, поэтому не лишним будет узнать об автоматизации поиска битых ссылок. Что используют в основном для поиска битых ссылок – старую проверенную временем Зенку или Xenu Links. Да, это отличный вариант для SEO оптимизаторов, но есть ещё одна шустрая программка — Screaming Frog SEO Spider, функционал которой намного шире чем у Зенки. Более того, она переходит по сайту по принципу Googlebot’а – это позволит отыскать битые ссылки, о которые может споткнуться Гуглбот. Ну а для того чтобы победить в этом противостоянии, необходимо «порхать как бабочка и жалить как пчела».

Весь функционал программы уже описан в этой статье «Функционал Screaming Frog SEO Spider». Мы же перейдем к практическому применению лягушонка – работе со структурой URL сайта с минимизацией критических ошибок, избегая потерь связи в линковке сайта, которая может вызвать потерю позиций в ПС.

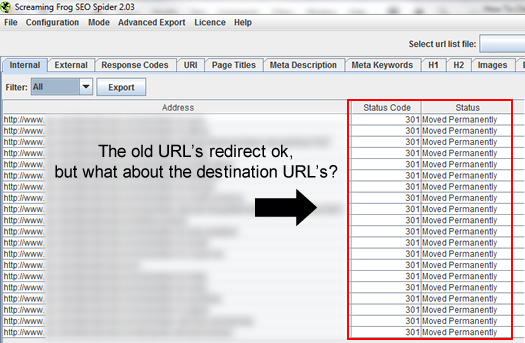

Обрисуем ситуацию: появляется желание перенести сайт, прибегаем к 301 редиректу, проверяем действительно ли используемый редирект переадресовывает к правильному URL. Но тут и скрывается основная хитрость — иногда старый URL при редиректе на новый URL может отрабатываться криво, т.е. вести в никуда, чего совсем не хочется. А ещё совсем не хочется искать такие кривые линки в окончательно выполненном проекте. Тут и вспоминаешь народную мудрость «Семь раз отмерь — один раз отрежь.

Казалось бы, чего тут сложного? Правим один домен на другой при помощи нужной директивы 301 редиректа в .htaccess и всё. Неопытные на этом останавливаются, а те, кто «не один пуд соли съел», точно знают, что это на бумаге просто взять запрос любого URL в одном домене и переадресовать его к тому же самому URL в другом домене, просто потому что это 301 редирект. Но в реальности всё куда более сложнее. Схематично это можно представить так:

Великолепно, работает, но не стоит торопиться. Давайте лучше спешить медленно, а значит не только заменить каждый запрос на 301 редирект, но и удостовериться в том, что переадресация отрабатывает, как надо – на нужные URL адреса. Иначе вас настигнет «безмолвный убийца» — SEO. Как вы уже заметили на скрине, он сделан в Screaming Frog –е, поэтому при помощи его мы и проверим точность переадресации во время редизайна или смены домена. Процесс будет двухступенчатый – чекаем редиректы и перепроверяем адресацию, а для этого воспользуемся импортированным списком исходных URL нашего сайта из отчёта, созданного в личном профиле GoogleAnalytics. Затем остаётся сделать несколько итераций парсинга лягушонком на наличие 404-ой и других технических ошибок, которые тут же можно исправить. Вроде просто, но для наглядности составим алгоритм действий:

- Во-первых, создаете для экспорта список проиндексированных страниц вашего сайта в своём профиле GoogleAnalytics.

- На втором шаге, в полученном списке? делаете автозамену при помощи Excel для построения полных URL адресов (список, созданный в Гугл Аналитексе, не содержит стартового значения домена).

- Далее копируете полученный спискок полных URL адресов из Экселя в блокнот для дальнейшего импортирования списка в скрименфрог.

- Импортируете список в лягошонка и производите парсинг.

- Получаете отчёт и выявляете проблемные места.

- Тщательно перепроверяете не только редиректы, но и точность URL адресации, помните, что цель – это битые ссылки.

- Делаете окончательную процедуру «лечения» выявленных ошибок.

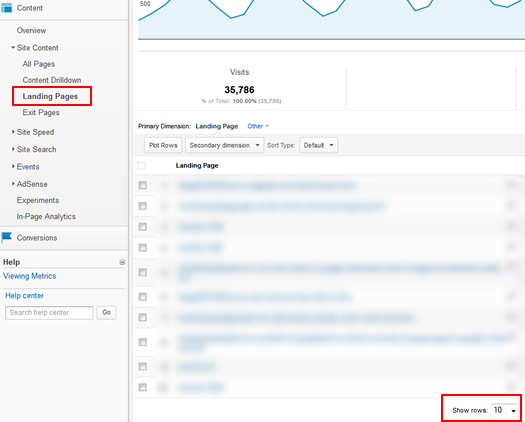

Создаём экспортный список в Google Analytics.

Авторизуйтесь в своём аккаунте Google Analytics. Последовательность действий следующая: вкладка «Content», раскрываете список «Site Content» и здесь выбираете «Landing Pages». Далее надо настроить режим отображения количества URL на странице (каждый настраивает по своему предпочтению, максимально доступно 50, нас это не устраивает — надо максимум).

Поэтому специально для тех, у кого количество страниц на сайте от 500 и выше, может воспользоваться такой фишкой – подредактировать URL в браузере. Для этого всего-навсего надо в конце адреса после «table.rowCount = подставить своё значение», то есть после знака равно указать 1000, 5000, 10000, так вы захватите максимальное количество URL.

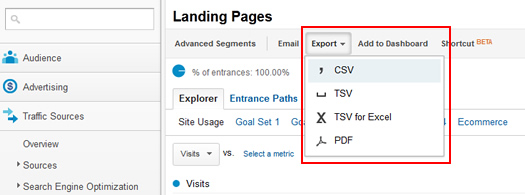

Экспорт CSV — отчета.

Щёлкаете по кнопке «Export» и среди предложенных вариантов выбираете предпочитаемый «CSV» формат для дальнейшего сохранения сгенерированного списка у себя на ПК. В последующем этот файл легко можно будет просмотреть и редактировать в Excel.

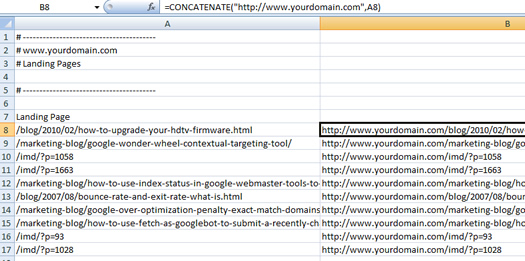

Конкатенация полного URL.

Excel вы будете использовать для связывания обрезанных url в экспортированном списке из Гугл Аналитикса с yourdomain.com, т.е. к каждому адресу добавляете исходный домен. Для этой процедуры подстановки воспользуйтесь функцией Excel по сцепке текста: открываете CSV-файл, в любую ячейку вносите свой домен yourdomain.com, который необходимо экранировать через решётку — «#». Далее перемещаете курсор в ячейку «B8» и в строке аргументов пишете следующую формулу:

=СЦЕПИТЬ(«www.yourdomain.com»; A8)

Данная функция «СЦЕПИТЬ» объединяет несколько частей текста в одну строку/ячейку. Аргументами функции СЦЕПИТЬ могут быть текстовые строки, числа, даты или ссылки на ячейки с данными, которые надо объединить в одну строку. В англоязычной версии Excel аналог функция CONCATENATE. , поэтому на скрине вы видите формулу:

=CONCATENATE (“http://www.yourdomain.com”, A8)

В вашем случае номер ячеек может не совпадать, поэтому значение ячеек меняйте под свой отдельный случай, главное помните, что формулу надо прописать именно в той ячейке, в которой вы хотите получить конечный результат. Далее остаётся левым нажатием мыши зацепить чёрную рамку вокруг ячейки «B8» и расширяя эту рамку, указать весь диапазон ячеек, которые должны быть заполнены итоговыми результатами. На выходе вы получите второй столбик URL, который будет содержать полные адреса.

Копипаст полученного списка URL.

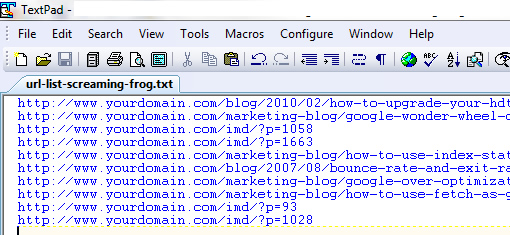

На данном этапе остаётся полученную колонку полных url скопировать в буфер обмена и, создав новый текстовый файл в блокноте или Textpad, вставить всё что скопировали, сохранить изменения в файле и смело переходить к следующему шагу.

Предварительные настройки Screaming Frog.

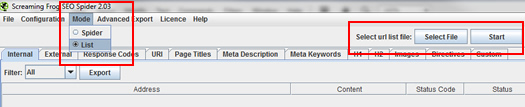

После того, как вы запустите Screaming Frog, необходимо изменить настройки по умолчанию на те, которые позволяют импортировать текстовые файлы. Для этого в меню программы выбираете вкладку «Mode» и активируете чекбокс «List», нажимаете в правом углу на «Select File» и указываете на ваш только что созданный текстовый файл. Когда программка подгрузит этот файл, можно смело нажимать на «Start».

Предварительный отчёт парсинга.

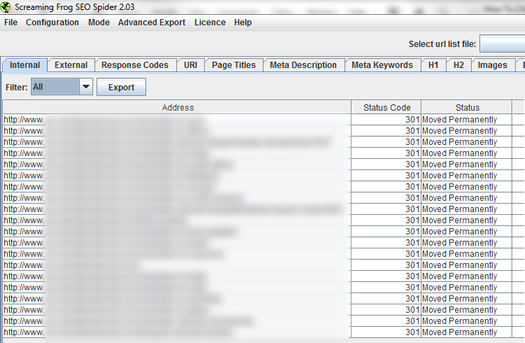

После первой итерации парсинга своего списка вы увидите подробный отчёт по всем URL, а также информацию по статус кодам этих адресов. Помните, что они должны показывать 301 редирект, что само по себе уже неплохо. Если не встречается 404-я ошибка, это верный признак того, что 301 редирект не переадресовывает по данному URL на новый адрес, но это мелкие баги, которые можно тут же пофиксить. Основные неприятности прячутся ещё глубже, поэтому продолжим дефектовку.

Не верь тому, что видишь.

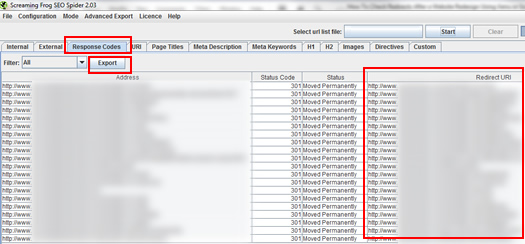

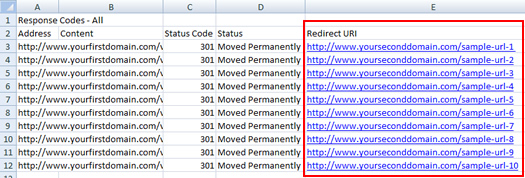

На выше представленном скрине вроде всё в порядке, везде значение статус кода – 301. Но Screaming Frog на то и слеплен, чтоб ходить по сайту, как Googlebot, поэтому, если вам не нравится результат и гложут смутные сомнения, то всегда можно их развеять практическим путём. Для этого всего-навсего надо перейти на вкладку «Response Codes» и воспользоваться кнопкой «Export» для создания списка фактических URL адресов (куда перенаправляет 301 редирект). Именно этот экспортированный отчёт из скрименфрога, содержащий Redirect URL, предстоит перепроверить на подводные камни — битые ссылки.

Шаманим список «мёртвых душ».

Экспортированный отчёт из скрименфрога, содержащий Redirect адреса, который вы получили в предыдущем шаге, тоже в экселевском формате, поэтому вновь повторяете действия: открываете файл в Excel, копируете столбец под названием «Redirect URl», создаёте ещё один текстовый файл в блокноте или текстпаде и вставляете из буфера обмена всё, что скопировали из экселя, сохраняете все изменения. Осталось сделать ещё одну итерацию парсинга в скрименфроге, как вы делали её до этого с редирект адресами, но на данном этапе процесс парсинга будет замкнут – цикличен, что в итоге гарантирует неискаженные результаты по адресуемым URL и достоверный отчёт по всем выявленным ложным редиректам.

Всю операцию импорта списка «мёртвых душ» в скрименфрог повторять не имеет смысла, так как все действия полностью идентичны операциям в шаге «Предварительные настройки Screaming Frog», лишь с той разницей, что список адресов будет другой.

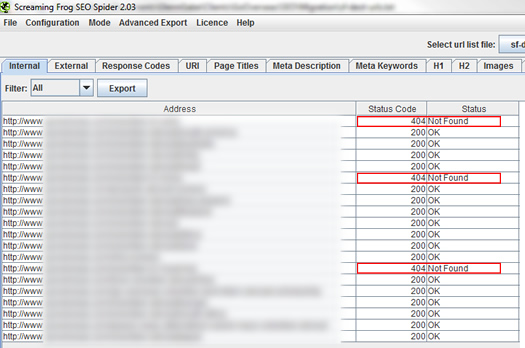

Окончательные результаты парсинга.

После того, как вы нажали «Старт», вы можете видеть ход обработки адресов и возвращаемые статус коды, в основном будут либо 200-й (успешный запрос), либо 404-я ошибка (то, что вы искали). Выявив все ложные срабатывания 301 редиректа и сами битые ссылки, нам остаётся в заключении ручками пофиксить все ошибки.

Как видите процесс монотонен, но эффект от него явный, вы избежите на сайте URL ведущих в НИКУДА, самое главное не забывайте о нём, если у вас стоит вопрос редизайна, смены хостинга или ещё каких либо трансформаций адресации ваших сайтов.

Скажем «нет» снижению ранжирования из-за не выявленного на ранней стадии «безмолвного убийцы» SEO. Желаю Вам всех благ и как можно меньше битых ссылок.

Перевод статьи: Alisa.

Оригинал статьи: hmtweb.com.