Если в любом поисковике задать запрос про PBN (private blog network), то в данный момент можно увидеть изобилие информации о том, какие домены для этого необходимы, на каких хостингах желательно размещать сайты, какой контент использовать и т.д. Но за кадром остаётся масса недосказанного, в том числе, как эффективно организовать внутреннюю и внешнюю перелинковку, чтобы сама сеть была замаскирована от негативных источников влияния, преимущественно от фильтров, санкций и факторов ранжирования поисковых систем.

Если в любом поисковике задать запрос про PBN (private blog network), то в данный момент можно увидеть изобилие информации о том, какие домены для этого необходимы, на каких хостингах желательно размещать сайты, какой контент использовать и т.д. Но за кадром остаётся масса недосказанного, в том числе, как эффективно организовать внутреннюю и внешнюю перелинковку, чтобы сама сеть была замаскирована от негативных источников влияния, преимущественно от фильтров, санкций и факторов ранжирования поисковых систем.

Давайте с вами рассмотрим такую ситуацию, когда приобретаются дроп-домены для приватных сеток сайтов. И тут вроде все делают по накатанной либо с самого домена-донора устанавливают 301 редирект на сайт-акцептор, стараясь усилить этим вес ранжирования сайта (подходит в тех случаях, например, когда нет копий сайта в web.archive.org, а в дополнительной выдаче поисковиков webcache в индексе находится всего несколько закешированных страниц сайта). Либо же прибегают к варианту, когда на дроп-доменах восстанавливают контент, дизайн, пытаясь сохранить естественность в «глазах» поисковых систем, получая этим максимальные квоты доверия.

Если с первым вариантом всё предельно ясно, ведь идёт переадресация, то со вторым вектором построения PBN возникают технические сложности. А именно, как быть с теми страницами сайтов, которых нет в веб-архиве, но на эти страницы размещены трастовые обратные ссылки? Разумеется, что логично будет прибегнуть к такому алгоритму, проставить 301 редирект на релевантные (тематические) страницы со страниц 404 ошибки, перенаправив пользователей на нужные URL-адреса. Таким образом, вес входящих внешних ссылок вновь будет передаваться дроп-сайту. Но есть ещё более топорный вариант — все внутренние URL-адреса приобретённого дроп-домена переадресовываются 301 редиректом на главную страницу самого сайта-донора, а уже потом с этой страницы перенаправление осуществляется на страницу сайта-акцептора, который входит в состав приватной сети. Но за прошедшие год-два такой подход утратил свою эффективность в силу того, что в результате данной перелинковки возникает коллизия, вызывающая обратный резонанс. Ведь очень странно будет выглядеть, когда сайт, заслуживающий доверия со стороны поисковых систем, в один прекрасный момент начинает редиректить все и вся на главную страницу. Мнения могут быть противоречивыми, но всем очевиден тот момент, что здесь присутствует огромный риск того, что все привлеченные ресурсы могут не дать в итоге желаемого результата, а именно буста ссылочной массы на продвигаемые проекты. Предварительный ответ понятен, надо снизить подобные риски, минимизировать потери и отойти от широко применяемых схем линкбилдинга.

Рассмотрим второй метод, при котором также будут задействованы 301 редирект, 404 страница, плюс секретный ингредиент (о нём чуть позже). Эффективность этого способа зиждится на динамической генерации 404 страницы, на которой дополнительно, помимо стандартных элементов — текстовки, графических изображений, — размещён динамический блок ссылок для перелинковки с другими своими сайтами-акцепторами. Сам же принцип генерации 404 страницы прост. На первоначальном этапе имеется первая версия страницы, которая, образно говоря, находится на вершине стека, в момент, когда эту страницу посещает поисковый робот, стартует счетчик, инициирующий сдвиг этой первой версии страницы вниз стека. Цифровой отсчёт запускает механизм создания второй копии 404 страницы с модифицированным блоком внешних ссылок. В итоге, когда поисковый робот покидает страницу, стек обновляется, и на его вершине теперь будет вторая версия 404 страницы, а первоначальная страница на второй позиции. Данный цикл можно повторять до бесконечности. Технически же все страницы, которые не на вершине стека, просто перемещаются, к примеру, во временный раздел сайта, где она уже не будет доступна никому, так как на её месте, на вершине стека, помещена вторая или н-ая версия 404 страницы, а сама исходная страница была переименована, например, в 404-0001. Таким образом, в результате получается, что на эту страницу нет ни внешних, ни внутренних URL-адресов (присутствуют только исходящие ссылки), она, по сути, становится фантомной страницей, которая в момент своего нахождения на вершине стека, имея свой ссылочный вес, передала его тем сайтам-акцепторам, на которые она ссылалась в динамическом блоке ссылок.

На языке SEO я получаю Orphan Pages (это сиротские страницы, которые не имеют ни внешних, ни внутренних ссылок, и для белого seo-продвижения это зло, так как при больших объёмах таких страниц распространено мнение, что они воруют и без того ограниченный краулинговый бюджет сайта). Но PBN — это не белая история, поэтому Orphan Pages здесь самое оно. Ведь самый очевидный плюс этого метода то, что не надо ничего дополнительно блокировать и маскировать, как это сейчас модно в высоко конкурентных нишах для того, чтобы ввести в заблуждение, скрыть реальную картину продвижения своих проектов и т. д. Это и есть секретный ингредиент, который даёт возможность передачи ссылочного веса и при этом иметь свойства скрытности обратных ссылок, ведь сами Orphan-страницы никому недоступны извне, кроме поисковых роботов. Но в любом случае владельцу сайта сложно предъявить «преднамеренные деструктивные» действия с Orphan pages, ведь поисковый робот со стопроцентной уверенностью неспособен определить, сделано ли это по хитрому умыслу или по случайности.

Иной противоестественный момент, когда на домен ставились ссылки, а после того как он дропнулся, процесс наращивания ссылочной массы прекратился. Поэтому резонно рассмотреть третий, самый эффективный метод, который даёт возможность расширения восстановленного дроп-домена путём добавления релевантных страниц, гармоничную передачу ссылочного веса, а также естественного продвижения в поисковых системах. Сам процесс прост в реализации. На сайте, к примеру, имеется иерархическая структура с пагинацией, которая включает в себя страницы категорий, затем контентные страницы:

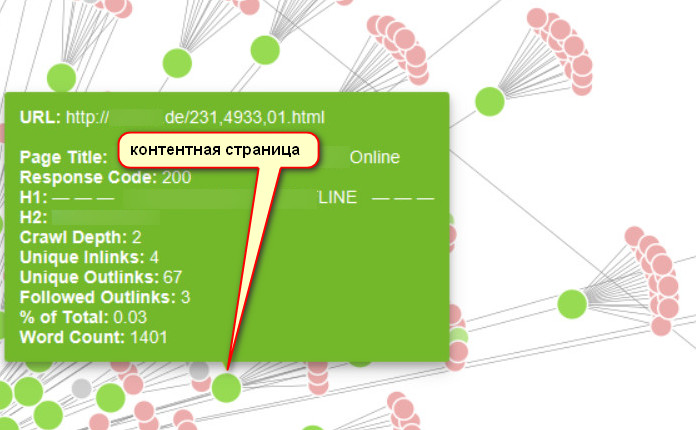

На скриншоте сами посадочные страницы представлены зелёными круглыми нодами, вот именно на этих контентных страницах сайта добавляются по 7-10 новых URL-адресов с единственной разницей в самой структуре адресации, а именно внедряется любой однотипный идентификатор:

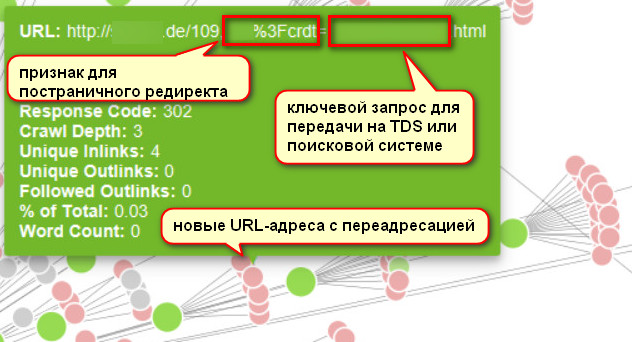

Розовые узлы демонстрируют иерархию связей с посадочными страницами всех новых URL-адресов со своим особым идентификатором, благодаря которому можно будет настроить постраничный 301 редирект через htaccess-файл с дополнительной возможностью передачи ключевого запроса из обновлённых гиперссылок на сайте в веб-адрес TDS (Traffic Delivery System), онлайн-магазина или просто поисковой системы. Сама строка из файла конфигурации сервера Apache выглядит так:

RewriteRule ^crdt=(.*).html http://google.de/search?q=site:Домен.de%20$1 [R=301,L]

Расшифровка данной строки:

- RewriteRule — функция Apache HTTP Server;

- ^crdt=(.*).html — фрагмент гиперссылки с уникальным идентификатором, который сохраняется в переменную для постраничного редиректа;

- http://google.de/search?q=site:Домен.de — это обычный фрагмент нового URL-адреса, куда должен быть передан ключевой запрос;

- site: — оператор Google, который ограничивает результаты поиска пределами одного сайта, что делает выдачу релевантнее;

- %20 — данный символ обозначает пробел в кодировке Unicode, нужен для поисковых роботов, иначе без него правило не сработает;

- $1 — это переменная, в которой сохранили нужный отрезок веб-адреса;

- [R=301,L] — код редиректа.

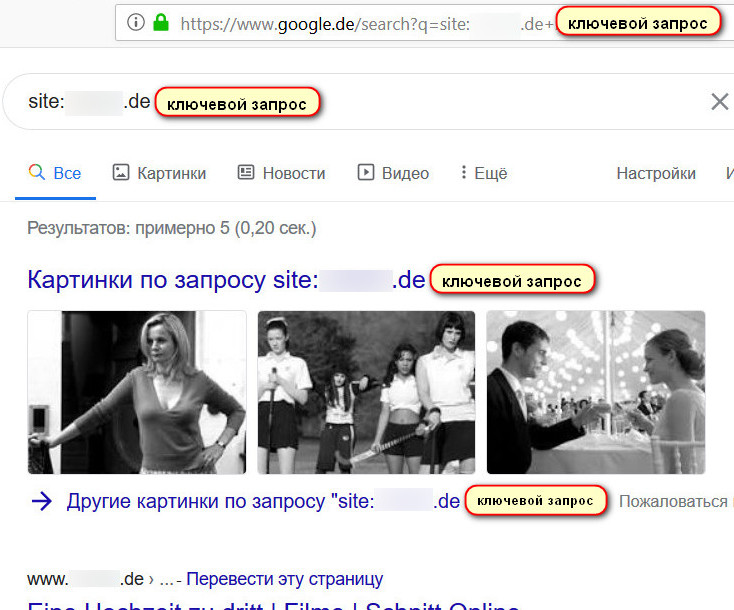

Разумеется, помимо самой внутренней перелинковки, которая проделана на сайте-доноре для размещения обновлённых гиперссылок с уникальным идентификатором, дополнительно проводятся работы по размещению внешних обратных ссылок на эти обновлённые URL-адреса. Получается, что сам процесс прироста ссылочной массы не приостановлен, а более того, на сайте есть обновления, и на эти новые страницы продолжают ссылаться другие сайты. Для чего же предпочтительна передача ключевой фразы в 301 редиректе, то тут всё предельно ясно — для аутентификации пользовательского запроса. В данном случае же идёт переадресация со скрытым манипулированием посетителей сайта через принудительное формирование поисковой выдачи, сама страница поисковика будет выглядеть примерно так:

Эффект такого перенаправления заключается в том, что если пользователи захотят посетить страницы, которые якобы находятся по новым размещённым на дроп-сайте URL-адресам, то они будут перенаправлены на страницу поисковой системы с уже предварительно сформированным ключевым запросом (на скриншоте визуально продемонстрировано, как навязчиво поисковик мотивирует пользователей посетить сайт). Далее две сюжетные линии развития событий: либо перейти по предложенным вариантам поисковиком, либо задать свой новый поисковый запрос, чтобы продолжить поиск. Согласно многочисленным аналитическим данным по исследованию поведения пользователей, можно сделать прогноз относительно того, что поскольку первое действие совершается в один клик, то его процент эффективности значительно выше, чем второго варианта, который предусматривает ввод иного поискового запроса с гораздо большей амплитудой потенциальных действий. Поэтому пользователь повторно возвращается на сайт с поисковой выдачи, а это сигнал к тому, что сайт ни много ни мало, но заслуживает некоторых преференций, так как один и тот же User-Agent посетил две разные страницы одного и того же сайта.

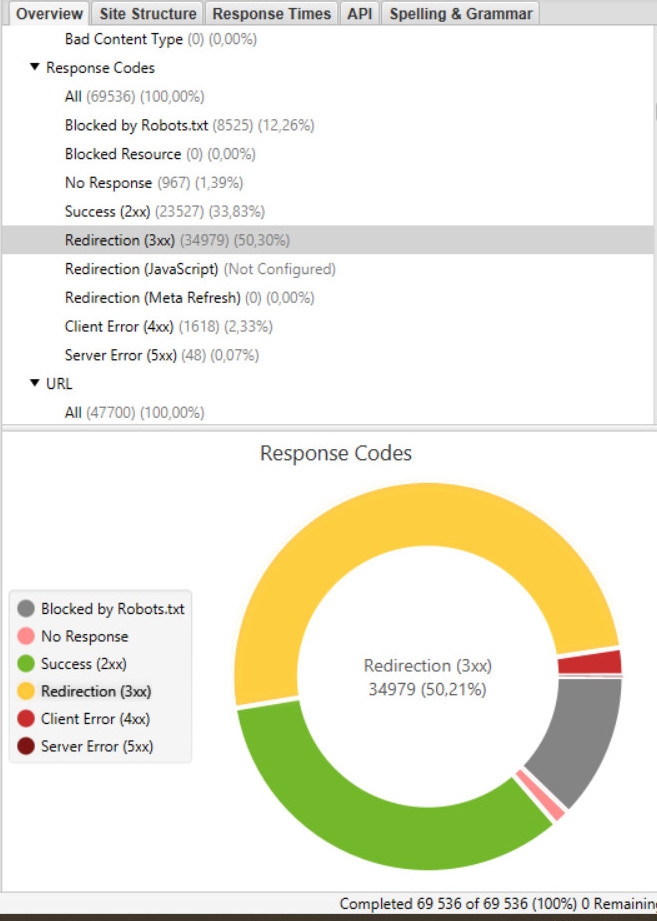

Показатель отказов (Bounce Rate — термин в веб-аналитике, обозначающий процентное соотношение количества посетителей, покинувших сайт прямо со страницы входа или просмотревших не более одной страницы сайта) будет, конечно же, ниже, ведь сами пользователи не просто посещают сайт, а возвращаются с поиска, переходя на внутренние страницы сайта. Тут присутствует положительная динамика — просмотр за сеанс визита сайта дальше его главной страницы. Относительно же аккумулирования и дальнейшей передачи ссылочного веса таким видом дропов своим проектам на практике показывает абсолютную рентабельность. Если в диаграммном срезе рассмотреть структуру такого сайта, то визуально можно увидеть характерную особенность: среди множества веб-страниц, которые отдают 200-код ответа сервера, будут доминировать страницы с 301 редиректом:

Практически более 50% всех URL-адресов. На первый взгляд, это слишком большая критическая масса, но есть хитрость, которая это всё нивелирует, а именно согласно одному из крайних сообщений сотрудника Google Джона Мюллера о 301 редиректе: «… это всего лишь сигнал к каноникализации. Вы сообщаете нам, что предпочитаете индексацию этой страницы, а не исходной». На практике получается, что Google делает склейку обратных ссылок, которые проставлены на новые страницы дроп-сайта со страницами своей поисковой выдачи, вроде в этом ничего криминального нет. Но есть одно условие, в чём отличие прямой обратной ссылки от внешнего беклинка, реализованного через 301 редирект, и разница в том, что во втором варианте присутствуют транзитные веб-страницы/url-адреса, которые по умолчанию получают часть ссылочного веса при внешнем линкбилдинге. А если учесть, что таких страниц с десяток, то идёт обычное аккумулирование веса с последующей передачей его дальше, вверх по иерархии внутренней структуры сайта.

Подводя итог, напомню, что все эти манипуляции имеют лишь одну цель — создание своих проектов на дропах для более динамического старта, который напрямую зависит как от алгоритмов ранжирования поисковых систем, так и от острой нехватки, а также для большей вариативности роста позиций сайта путём наращивания ссылочной массы.

Автор статьи: Alisa.